腾讯混元DiT再升级:推出6G小显存版本

7 月 4 日消息,今日,腾讯混元文生图大模型(混元 DiT)宣布开源小显存版本,仅需 6G 显存即可运行,对使用个人电脑本地部署的开发者十分友好,该版本与 LoRA、ControlNet 等插件,都已适配至 Diffusers 库;并新增对 Kohya 图形化界面的支持,让开发者可以低门槛地训练个性化 LoRA 模型;同时,混元 DiT 模型升级至 1.2 版本,在图片质感与构图方面均有所提升。

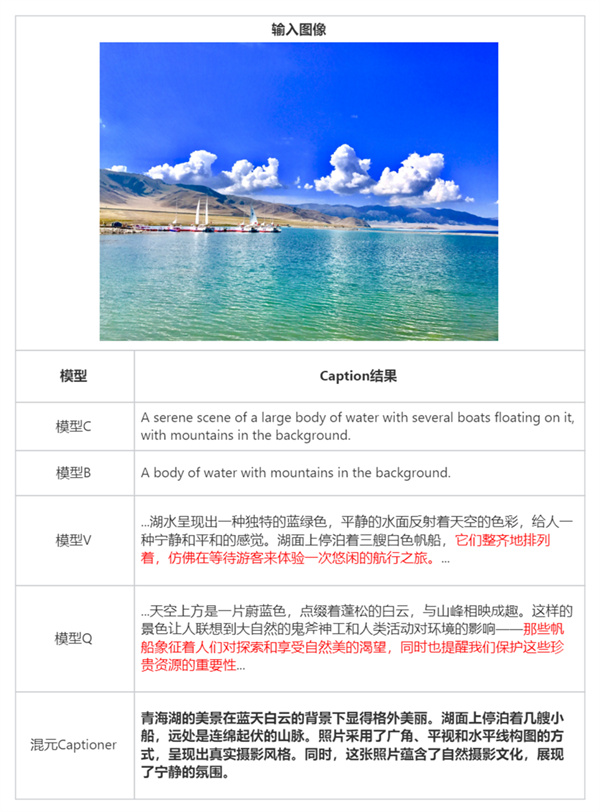

此外,腾讯宣布混元文生图打标模型”混元 Captioner“正式对外开源。该模型支持中英文双语,针对文生图场景进行专门优化,可帮助开发者快速制作高质量的文生图数据集。

腾讯混元 DiT 模型宣布了三大更新:推出小显存版本与 Kohya 训练界面,并升级至1.2版本,进一步降低使用门槛的同时提升图片质量。

基于 DiT 架构的文生图模型生成图片质感更佳,但对显存的要求却非常高,让许多开发者望而却步。这也是新版本 Stable Diffusion 模型无法快速普及的原因之一。

在提升模型易用性的同时,腾讯混元团队也在开放更多的关键技术,包括此前的训练代码,最新的打标模型混元 Captioner。

免责声明:本文为转载,非本网原创内容,不代表本网观点。其原创性以及文中陈述文字和内容未经本站证实,对本文以及其中全部或者部分内容、文字的真实性、完整性、及时性本站不作任何保证或承诺,请读者仅作参考,并请自行核实相关内容。

如有疑问请发送邮件至:goldenhorseconnect@gmail.com

- 王都创世录添加好友有什么作用2024-09-25

- 《魔兽世界》wlk美酒节饰品可获取数量介绍2024-09-25

- 和平精英动物丛林上线时间介绍2024-09-25

- 《魔兽世界》wlk拯救美酒节间谍位置介绍2024-09-25

- 白荆回廊谎言之下烙痕效果有哪些2024-09-25

- 《魔兽世界》wlk寇仁恐酒位置介绍2024-09-25

- 沙威玛传奇包装纸可升级次数说明2024-09-25

- 《魔兽世界》wlk拯救美酒节攻略2024-09-25

- 公主连结atk含义解析一览 公主连结atk含义解析介绍2024-09-25

- 《魔兽世界》美酒节粉色小象捕捉方法介绍2024-09-25